AI相互検証メカニズムは本当に力強い、信頼はこうやって築くべきだ!

原文表示Meta11

現在、コンテンツはありません

Meta11

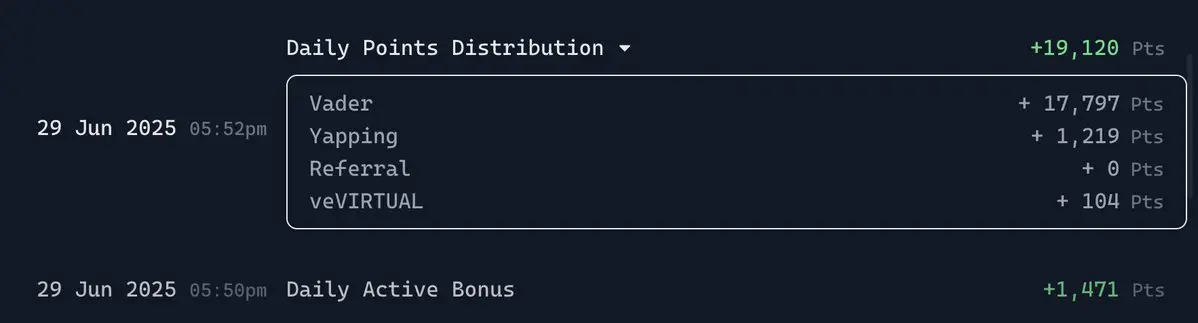

最近Frescoというプロジェクトを見かけました。初めて見るとMidjourneyのような類似製品だと思いましたが、深入りしてみると、実際には単なる「画像生成ツール」ではなく、「あなたと幻想世界との対話」のようです。

FrescoはMiraの世界にサービスを提供する、幻想的な雰囲気に満ちた設定宇宙で、そこに登場するのは一群の騎士です。しかし、これらの騎士はシステムによってランダムに割り当てられるのではなく、ユーザーがプロンプトを書いて自ら「召喚」したものです。

毎日一度だけ一言を書く機会があります。この言葉はあなたのその日の召喚儀式になります。あなたが書いたのはどんなシーンであれ、それはあなたにその行動をする騎士を与えてくれます。人物を描くのではなく、キャラクターです。この感覚は、あなたが思いつきを抱くようなもので、その後 Mira が生きたキャラクターであなたに応えてくれるようなものです。

さらにすごいのは、この騎士のスタイル、気質、動きが、Miraの美学体系を持っていることです。少し中世のレトロな感じがあります。見た目は、使命を持っている個体のようです。

Frescoの回数制限は、逆にそれを最も魅力的な点にしています。あなたには1日に1回のチャンスしかなく、撤回もやり直しもできません。これは、各プロンプトの背後に生成されるのは単なる画像だけでなく、キャラクターの運命でもあること

FrescoはMiraの世界にサービスを提供する、幻想的な雰囲気に満ちた設定宇宙で、そこに登場するのは一群の騎士です。しかし、これらの騎士はシステムによってランダムに割り当てられるのではなく、ユーザーがプロンプトを書いて自ら「召喚」したものです。

毎日一度だけ一言を書く機会があります。この言葉はあなたのその日の召喚儀式になります。あなたが書いたのはどんなシーンであれ、それはあなたにその行動をする騎士を与えてくれます。人物を描くのではなく、キャラクターです。この感覚は、あなたが思いつきを抱くようなもので、その後 Mira が生きたキャラクターであなたに応えてくれるようなものです。

さらにすごいのは、この騎士のスタイル、気質、動きが、Miraの美学体系を持っていることです。少し中世のレトロな感じがあります。見た目は、使命を持っている個体のようです。

Frescoの回数制限は、逆にそれを最も魅力的な点にしています。あなたには1日に1回のチャンスしかなく、撤回もやり直しもできません。これは、各プロンプトの背後に生成されるのは単なる画像だけでなく、キャラクターの運命でもあること

PROMPT-1.12%

- 報酬

- いいね

- コメント

- 共有

最近見たキーワードは「AI著作権戦」です。主な問題は誰が侵害しているかではなく、AI産業全体が他人の資源を掘り、自分のビルを建てているのかどうかです。

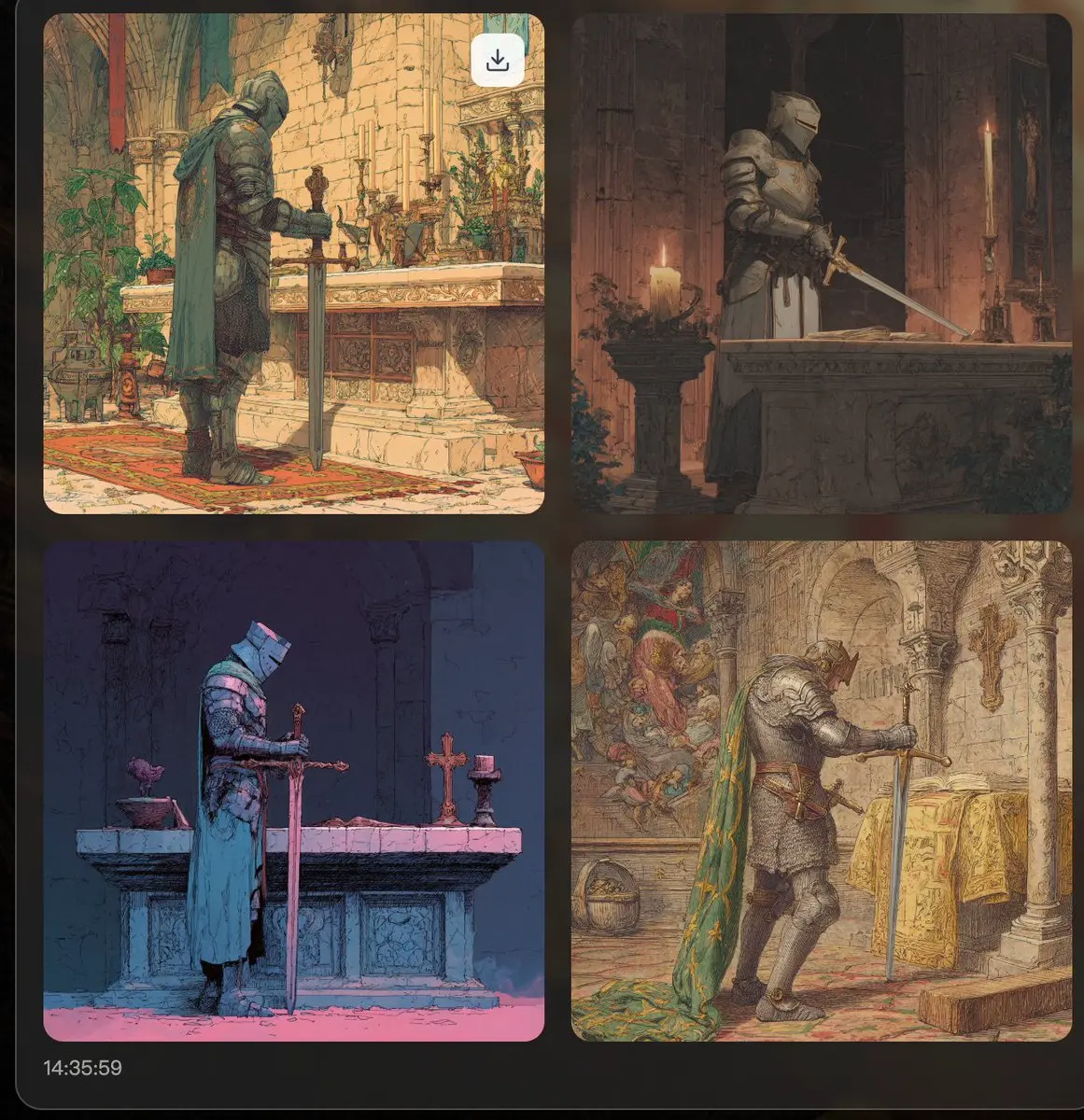

RedditがAnthropicを告訴し、GettyがStability AIを告訴し、DisneyがMidjourneyを訴えるという一連の大手企業によるAI企業への集団反撃は、一見すると個別の事件のように見えますが、実際には同じ核心的な問題が背後にあります。AIモデルは、許可を得ることなく、ネット上からクリエイターのコンテンツを大量に取得してモデルを訓練しています。

この問題の本質は技術的な問題ではなく、利益分配の問題です。AI企業はコンテンツクリエイターの労働成果を借りていますが、何の報酬も与えていません。これはゼロサムゲームではなく、明らかな強奪です。現実の状況は、AI産業がクリエイターの労働から鉱石を掘り出している一方で、その利益とコントロール権はごく少数のテクノロジー企業に集中しています。

@campnetworkxyz は AI と対抗するのではなく、AI とクリエイターが共にウィンウィンの関係を築くことです。チェーン上の著作権 + スマートコントラクト + 検証可能なライセンスシステムに基づく新しい秩序を構築し、クリエイターの貢献が見える化され、認識され、報われるようにします。

Campの基本的な考え方は、ブロックチ

RedditがAnthropicを告訴し、GettyがStability AIを告訴し、DisneyがMidjourneyを訴えるという一連の大手企業によるAI企業への集団反撃は、一見すると個別の事件のように見えますが、実際には同じ核心的な問題が背後にあります。AIモデルは、許可を得ることなく、ネット上からクリエイターのコンテンツを大量に取得してモデルを訓練しています。

この問題の本質は技術的な問題ではなく、利益分配の問題です。AI企業はコンテンツクリエイターの労働成果を借りていますが、何の報酬も与えていません。これはゼロサムゲームではなく、明らかな強奪です。現実の状況は、AI産業がクリエイターの労働から鉱石を掘り出している一方で、その利益とコントロール権はごく少数のテクノロジー企業に集中しています。

@campnetworkxyz は AI と対抗するのではなく、AI とクリエイターが共にウィンウィンの関係を築くことです。チェーン上の著作権 + スマートコントラクト + 検証可能なライセンスシステムに基づく新しい秩序を構築し、クリエイターの貢献が見える化され、認識され、報われるようにします。

Campの基本的な考え方は、ブロックチ

IP-0.92%

- 報酬

- いいね

- コメント

- 共有

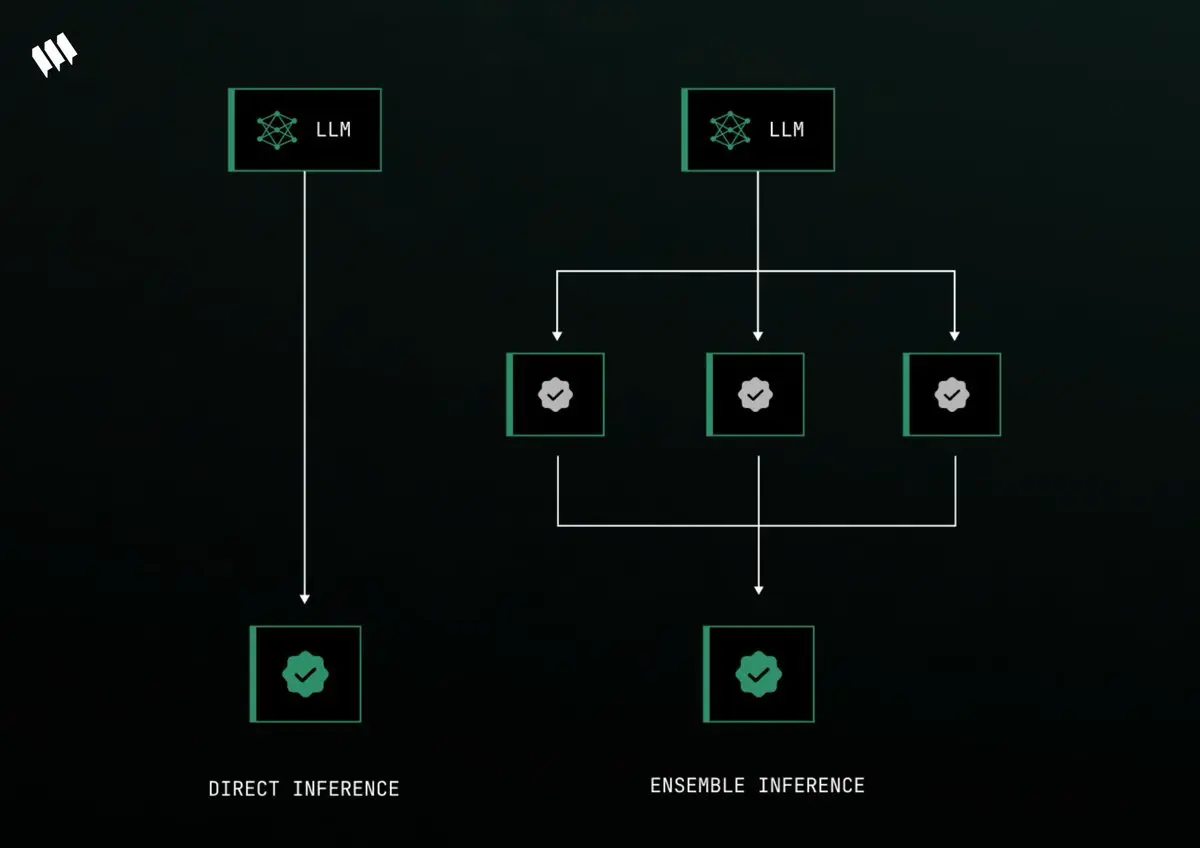

@Mira_Network の作業メカニズムから、AIが真実を語っているかどうかを見分ける方法を解説します!

現在のほとんどのLLMモデルを使用したAIは、しばしば真剣に無意味なことを言っており、実際には信頼性を持つことができません。技術の問題ではなく、原理的に制限が存在し、正確かつ中立であることを同時に求めることができないのです。

データを多く訓練するほど、偏見を減らすことができますが、物語を作り始める可能性があります。データがクリーンであればあるほど、特定の立場に偏る可能性があります。

Miraのコアメカニズムはコンセンサス検証です。実際には、1つのモデルの回答に依存せず、複数のモデルが一緒に判断に参加します。全員が「はい」と言ったときのみ、この回答は検証を通過したと見なされます。

全体のプロセスは以下の3つのステップに分かれています!

1⃣バイナリゼーション

AIの回答は一つの段落で判断するのではなく、一文一文の小さな判断に分けるべきです。

例えば:地球は太陽の周りを回り、月は地球の周りを回ります。

Miraはこの文を次のように分けます:

地球は太陽の周りを回っている

月が地球の周りを回る

各文は独立して検証されます。これにより、全体としては正しいように聞こえるが、実際には詳細がすべて間違っているという問題を回避します。

2⃣ 分散検証

これらの分割された文は、Miraネット

現在のほとんどのLLMモデルを使用したAIは、しばしば真剣に無意味なことを言っており、実際には信頼性を持つことができません。技術の問題ではなく、原理的に制限が存在し、正確かつ中立であることを同時に求めることができないのです。

データを多く訓練するほど、偏見を減らすことができますが、物語を作り始める可能性があります。データがクリーンであればあるほど、特定の立場に偏る可能性があります。

Miraのコアメカニズムはコンセンサス検証です。実際には、1つのモデルの回答に依存せず、複数のモデルが一緒に判断に参加します。全員が「はい」と言ったときのみ、この回答は検証を通過したと見なされます。

全体のプロセスは以下の3つのステップに分かれています!

1⃣バイナリゼーション

AIの回答は一つの段落で判断するのではなく、一文一文の小さな判断に分けるべきです。

例えば:地球は太陽の周りを回り、月は地球の周りを回ります。

Miraはこの文を次のように分けます:

地球は太陽の周りを回っている

月が地球の周りを回る

各文は独立して検証されます。これにより、全体としては正しいように聞こえるが、実際には詳細がすべて間違っているという問題を回避します。

2⃣ 分散検証

これらの分割された文は、Miraネット

原文表示

- 報酬

- いいね

- コメント

- 共有

ちょうど @TheoriqAI の投稿を見ました。TheoRooAI と Yapybara が「暗い森からの脱出」を語り、自動運転の旅に踏み出す様子は、AlphaSwarm が約束したように、DeFi の信頼を一歩ずつ勝ち取っていくのと同じです。

彼らは漫画の形式でAIエージェントが分散型金融の世界で、まるで車を運転して探索するように、信頼を築くためにマイルを積み重ねる必要があることを表現したいと思っています。

AlphaSwarmは、Theoriqが立ち上げたAgent Swarmツールキットであり、その中核は、Python SDKの完全なセットを使用して、クロスチェーン取引、流動性補充、利回り最適化、およびその他の自動化戦略を実現するためのLLM駆動型AI金融エージェントを迅速に構築することです。

それは3つの役割を代理で組み合わせた閉じたシステムを作り出します。Portal Agentはユーザーの状態を監視し、Knowledge Agentは戦略分析のためのデータを引き出し、LP Assistantは実行可能なコードの提案を生成し、最終的にワンクリックで取引を行います。プロセスは透明で安全であり、ユーザーの資産は常に自己管理されています。

このような分業モデルは実際にはチーム協力です。各エージェントが特定の部分を担当し、一緒に協力して複雑なタスクを完了します。

それに裏打ちさ

原文表示彼らは漫画の形式でAIエージェントが分散型金融の世界で、まるで車を運転して探索するように、信頼を築くためにマイルを積み重ねる必要があることを表現したいと思っています。

AlphaSwarmは、Theoriqが立ち上げたAgent Swarmツールキットであり、その中核は、Python SDKの完全なセットを使用して、クロスチェーン取引、流動性補充、利回り最適化、およびその他の自動化戦略を実現するためのLLM駆動型AI金融エージェントを迅速に構築することです。

それは3つの役割を代理で組み合わせた閉じたシステムを作り出します。Portal Agentはユーザーの状態を監視し、Knowledge Agentは戦略分析のためのデータを引き出し、LP Assistantは実行可能なコードの提案を生成し、最終的にワンクリックで取引を行います。プロセスは透明で安全であり、ユーザーの資産は常に自己管理されています。

このような分業モデルは実際にはチーム協力です。各エージェントが特定の部分を担当し、一緒に協力して複雑なタスクを完了します。

それに裏打ちさ

- 報酬

- いいね

- コメント

- 共有

誰がこっそりあなたの💰を盗んだの?誰もが知っているように、AIの基盤となる論理は養うことから離れられず、AIを養う燃料は当然「データ」です。以前NFTを頑張っていた頃、誰がコミュニティのために二次創作の画像を作ることを考え出したのか思い出せないが、たくさんの「落第した美術生」が職業人生の第二の春を迎えることになったため、多くの人が周りの美術を学んでいる人を探してスタジオを作った。質の高いものに応じて、価格は50から500の間で異なります。今の時代、コミュニティに関連する素材画像をそのままAIに投入して、たくさんの二次創作を生成するのは、間違いなく時間がかかるが、労力はかからない。

ちょうど @campnetworkxyz が発表したデータについて、DataComp CommonPool のサンプリング監査を見かけました。わずか0.1%の作品をサンプリング監査しただけで、数千もの未承認のクリエイターの作品が含まれていることがわかりました。そして、これらのデータは現在の商業AIモデルの核心的なトレーニング材料です。言い換えれば、大規模モデルはあなたに属すべきお金を奪い、あなたは分け前を得られなかったのです。

創作者は苦しむ機会すらないと言える。なぜなら、ほとんどのモデルのトレーニング期間は2014年から2022年で、その頃にはどのプロトコルの許可やロイヤリティメカニズムについての認識

ちょうど @campnetworkxyz が発表したデータについて、DataComp CommonPool のサンプリング監査を見かけました。わずか0.1%の作品をサンプリング監査しただけで、数千もの未承認のクリエイターの作品が含まれていることがわかりました。そして、これらのデータは現在の商業AIモデルの核心的なトレーニング材料です。言い換えれば、大規模モデルはあなたに属すべきお金を奪い、あなたは分け前を得られなかったのです。

創作者は苦しむ機会すらないと言える。なぜなら、ほとんどのモデルのトレーニング期間は2014年から2022年で、その頃にはどのプロトコルの許可やロイヤリティメカニズムについての認識

IP-0.92%

- 報酬

- いいね

- コメント

- 共有

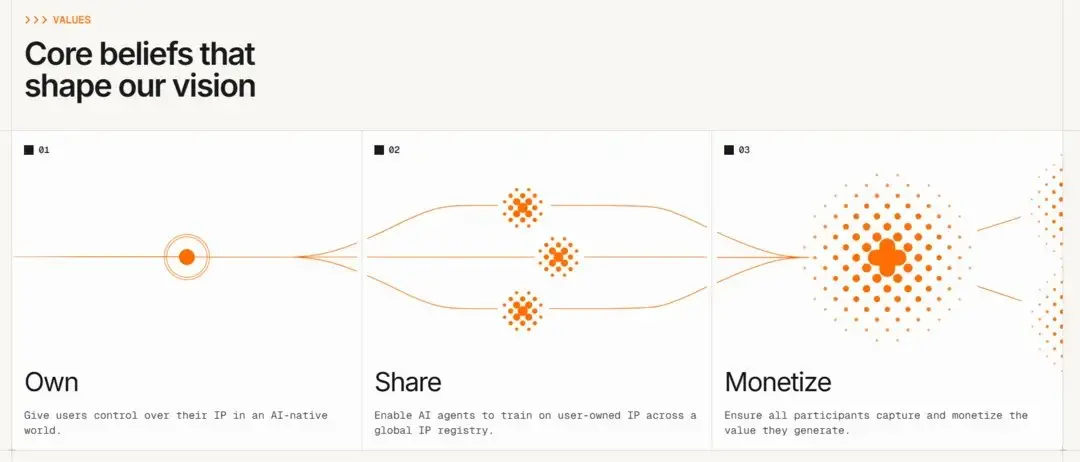

現在、Campでコンテンツを共創している人々は、実際には「初期ユーザー」だけではなく、全体の新しいIP経済システムの真の「権益者」です。

この文は少し抽象的に聞こえますが、現在 @campnetworkxyz で創作されているすべての物語、すべての画像、すべての派生IPは、AIモデルのトレーニング、商業ライセンス、さらには映画化における「データ資産ノード」になる可能性があります。そして、創作者はそのノードの原初的な貢献者であり、合法的な権利者です。

結局のところ、Campが構築しようとしているのは「チェーン上の権利確定+AIトレーニングデータ」を基盤とした新しいIP経済モデルです。

従来のコンテンツ制作では、作品を収益化するためには、プラットフォームの管理から商業化の難しさ、さらには最終的な利益配分まで、すべての中央集権的なプロセスを経る必要があります。これはクリエイターにとって非常に不利です。しかし、Campのロジックは「チェーン上の権利確認」から始まります。画像、一つのキャラクター設定、一段のストーリー、さらには特定の分岐ストーリーの「二次創作」であっても、Campにおいてチェーンに載せられれば、それには自動的にプロヴェナンス(出所)と追跡可能な制作記録が付随します。

今回のCampとSaharaのコラボレーションは非常に象徴的です。彼らはOrigin、mAItrixなどCam

原文表示この文は少し抽象的に聞こえますが、現在 @campnetworkxyz で創作されているすべての物語、すべての画像、すべての派生IPは、AIモデルのトレーニング、商業ライセンス、さらには映画化における「データ資産ノード」になる可能性があります。そして、創作者はそのノードの原初的な貢献者であり、合法的な権利者です。

結局のところ、Campが構築しようとしているのは「チェーン上の権利確定+AIトレーニングデータ」を基盤とした新しいIP経済モデルです。

従来のコンテンツ制作では、作品を収益化するためには、プラットフォームの管理から商業化の難しさ、さらには最終的な利益配分まで、すべての中央集権的なプロセスを経る必要があります。これはクリエイターにとって非常に不利です。しかし、Campのロジックは「チェーン上の権利確認」から始まります。画像、一つのキャラクター設定、一段のストーリー、さらには特定の分岐ストーリーの「二次創作」であっても、Campにおいてチェーンに載せられれば、それには自動的にプロヴェナンス(出所)と追跡可能な制作記録が付随します。

今回のCampとSaharaのコラボレーションは非常に象徴的です。彼らはOrigin、mAItrixなどCam

- 報酬

- いいね

- コメント

- 共有

- 報酬

- いいね

- コメント

- 共有

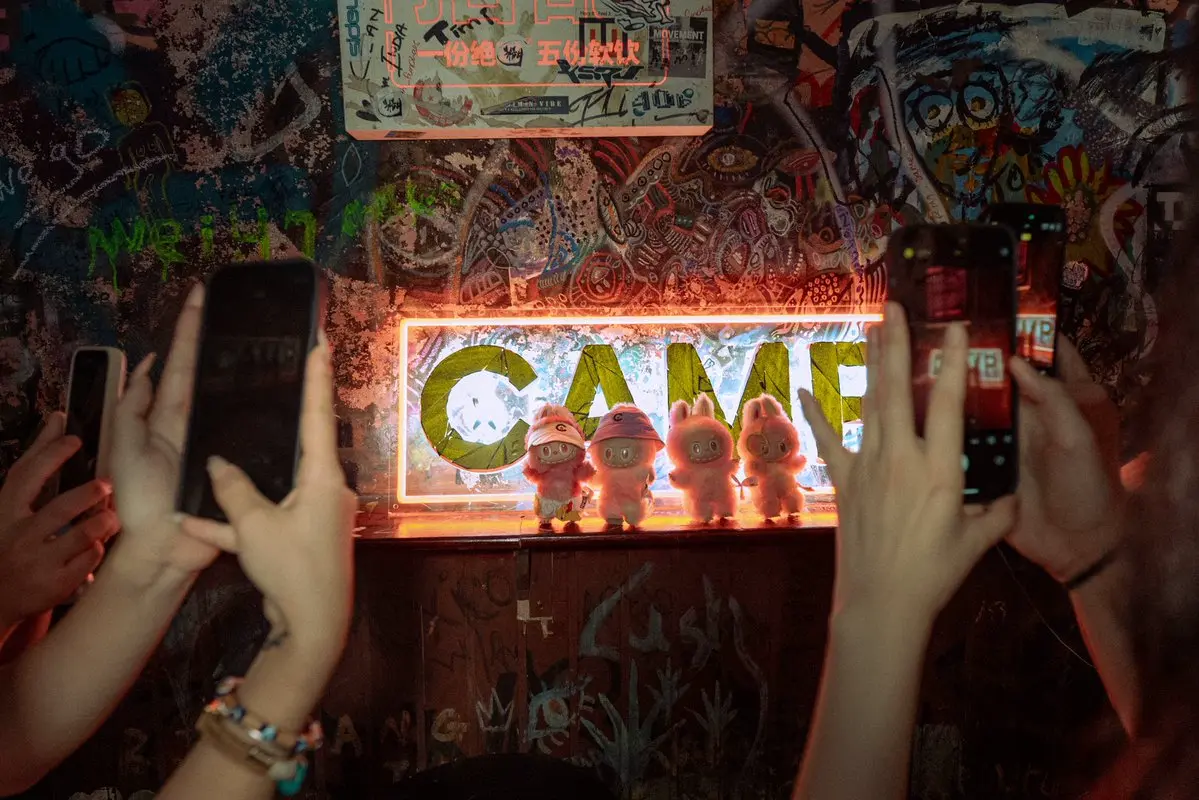

短短不到一周、すでに 15 万ページのコンテンツが Camp で mint 出されました、そして各ページはオンチェーンで検証可能、著作権が明確で、トレーサビリティがあります。誰が書いたかわからないAI生成のコンテンツではなく、真の意味で「ソースのある共創」です。

このことは私に1つの問題を思い出させます——以前、私たちはコンテンツ制作の価値が非常に大きいと言っていましたが、結局それは誰のものなのでしょうか?多くのプラットフォームはあなたの大部分のコントロール権と収益権を奪い、あなたが書いたものはプラットフォームのアルゴリズムを訓練するための「燃料」となってしまいます。

そして、Camp + StoryChainというこの一連のシステムは、実際には新しい「コンテンツ協力協定」の一種です:

1️⃣あなたが書いた内容は、あなたのIPとして明確にマークできます

2️⃣AIの参加プロセスは透明であり、検証可能です。

3️⃣各ページの創作はオンチェーン資産としてmintされます

4️⃣ユーザーは利益分配に参加でき、著作権の帰属があります。

私の見解では、これは単なる物語を書く活動ではなく、「コンテンツ配信の新しいモデル」のベータ版のようなものです:ユーザーから出発し、AIが創作を支援し、そしてブロックチェーンを通じて帰属と価値の還流を保証します。要するに、コアロジックはユーザーの共創、AIの拡

原文表示このことは私に1つの問題を思い出させます——以前、私たちはコンテンツ制作の価値が非常に大きいと言っていましたが、結局それは誰のものなのでしょうか?多くのプラットフォームはあなたの大部分のコントロール権と収益権を奪い、あなたが書いたものはプラットフォームのアルゴリズムを訓練するための「燃料」となってしまいます。

そして、Camp + StoryChainというこの一連のシステムは、実際には新しい「コンテンツ協力協定」の一種です:

1️⃣あなたが書いた内容は、あなたのIPとして明確にマークできます

2️⃣AIの参加プロセスは透明であり、検証可能です。

3️⃣各ページの創作はオンチェーン資産としてmintされます

4️⃣ユーザーは利益分配に参加でき、著作権の帰属があります。

私の見解では、これは単なる物語を書く活動ではなく、「コンテンツ配信の新しいモデル」のベータ版のようなものです:ユーザーから出発し、AIが創作を支援し、そしてブロックチェーンを通じて帰属と価値の還流を保証します。要するに、コアロジックはユーザーの共創、AIの拡

- 報酬

- いいね

- コメント

- 共有

今、D'CENTはウォレットとしてCampにも接続されており、実際にはこのチェーンのベースエコシステムが実際の使用シーンに近づき始めたことを意味しています。

もしあなたがクリエイターであれば、たとえ気軽に動画を撮ったり、絵を描いたり、文章を書いたりしたとしても、これらのコンテンツは今ではプラットフォームにアップロードして少しの流量を得るしかありません。しかし今では D’CENT によってブロックチェーン登録を行い、すべての AI モデルやユーザーに明確に伝えることができます:このコンテンツは私のオリジナルであり、使用権、許可権、及び収益権を保留します。

この背後の核心的な論理は、Campが推進する「Proof of Provenance」——検証可能な出所証明です。オンチェーンで記録されているため、追跡可能です。プラットフォームは勝手に変更できず、AIモデルを使用するには料金が必要で、収益は契約に基づいて支払われます。これは従来の「コンテンツプラットフォームの分配モデル」よりもはるかにクリーンです。

コンテンツ自体が資産であるという論理から出発し、クリエイターを中心に完全なオンチェーン経済のクローズドループを構築します。生成から、権利確定、許可、収益まで、全プロセスを完了させ、さらにはこれらのデータをAIモデルのトレーニングに公開し、透明で追跡可能なトレーニングデータに変えることが

原文表示もしあなたがクリエイターであれば、たとえ気軽に動画を撮ったり、絵を描いたり、文章を書いたりしたとしても、これらのコンテンツは今ではプラットフォームにアップロードして少しの流量を得るしかありません。しかし今では D’CENT によってブロックチェーン登録を行い、すべての AI モデルやユーザーに明確に伝えることができます:このコンテンツは私のオリジナルであり、使用権、許可権、及び収益権を保留します。

この背後の核心的な論理は、Campが推進する「Proof of Provenance」——検証可能な出所証明です。オンチェーンで記録されているため、追跡可能です。プラットフォームは勝手に変更できず、AIモデルを使用するには料金が必要で、収益は契約に基づいて支払われます。これは従来の「コンテンツプラットフォームの分配モデル」よりもはるかにクリーンです。

コンテンツ自体が資産であるという論理から出発し、クリエイターを中心に完全なオンチェーン経済のクローズドループを構築します。生成から、権利確定、許可、収益まで、全プロセスを完了させ、さらにはこれらのデータをAIモデルのトレーニングに公開し、透明で追跡可能なトレーニングデータに変えることが

- 報酬

- いいね

- コメント

- 共有

最も一般的な例を挙げると、GPTを使って財務データ分析、産業機器の監視、医療文書の分類を行うと、大部分の出力結果は、質問に対して無関係であったり、プロンプトを必死に調整し続けなければならなくなります。最終的には、GPTがあなたが求めているものを理解しているのかどうかも分からなくなってしまいます。

もちろん、多くの人が言いたいのは、AIモデルは訓練を続けるプロセスではないかということです。十分なデータを与えれば、彼はあなたが考えていることを理解し、あなたが求めるものを提供するはずです。しかし、実際にはそうではありません。個人にとって最も理想的な方法は、自分専用のAIモデルを作成し、自分のデータを理解し、自分のビジネスに適応させることです。

しかし、実際に直面する問題は次々とやってきます。これらを実現するための前提は、大量のデータ、モデルをトレーニングする人、そして最も重要なのはモデルを実行するためのインフラストラクチャが必要であり、基本的に90%の人を退かせることができます。

1️⃣ヒント呼び出しインターフェース

任意のデプロイ済みのSLM(Specialized Language Model)には、/v1/completionsインターフェースを介して直接アクセスできます。

適応範囲は非常に広い:AIボット、オンチェーン推論、さらにはゲームスクリプトにも使用できます。

2️⃣モデル

原文表示もちろん、多くの人が言いたいのは、AIモデルは訓練を続けるプロセスではないかということです。十分なデータを与えれば、彼はあなたが考えていることを理解し、あなたが求めるものを提供するはずです。しかし、実際にはそうではありません。個人にとって最も理想的な方法は、自分専用のAIモデルを作成し、自分のデータを理解し、自分のビジネスに適応させることです。

しかし、実際に直面する問題は次々とやってきます。これらを実現するための前提は、大量のデータ、モデルをトレーニングする人、そして最も重要なのはモデルを実行するためのインフラストラクチャが必要であり、基本的に90%の人を退かせることができます。

1️⃣ヒント呼び出しインターフェース

任意のデプロイ済みのSLM(Specialized Language Model)には、/v1/completionsインターフェースを介して直接アクセスできます。

適応範囲は非常に広い:AIボット、オンチェーン推論、さらにはゲームスクリプトにも使用できます。

2️⃣モデル

- 報酬

- 8

- 4

- 共有

Waqar56 :

:

素晴らしいもっと見る

もし今日、あなたがWeb3アプリケーションのアーキテクチャ全体を再設計することになったら——どこから始めますか?

いわゆるインテント中心のアーキテクチャとは、「ユーザーが何を望んでいるか」を最優先のニーズに変えることであり、もはやボタンの背後に隠されたパラメータではなく、システム全体の運営の中心です。

ユーザーは「何をしたいか」を説明するだけで、残りのマッチング、条件の制約、相手方の検索、最終的な納品はすべてシステムによって自動的に調整されます。

例えば、私は言います:「100個のstETHを同等のRWA資産に交換したい。最適なコストパフォーマンスで、今日中に完了する必要があります。」

自分でこのアクションを実行する場合は、アグリゲーターを使ってルーティングするか、複数のプールで注文を出して比較し、取引が成立するのを待つ必要がありますが、必ずしも達成できるわけではありません。しかし、インテント中心のシステムでは、この要求は明確な意図に分解され、能力のあるソルバーに処理してもらうために広められ、決済されます。

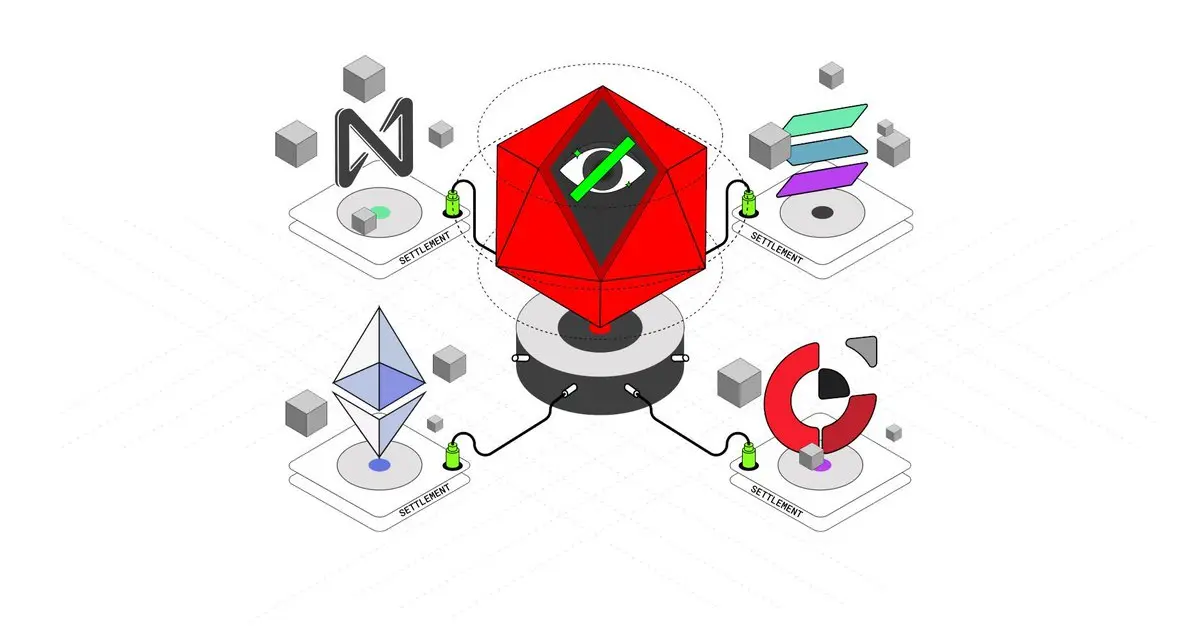

Anomaはこのシステムを4つの主要なモジュールに分解しています:

1⃣インテント:ユーザーの希望と制約

2⃣カウンターパーティー発見:マッチングできる相手を見つける

3⃣解決:最適なプランを見つける

4⃣決済:最終的な引渡しとオンチェーンでの合意

この4つの要素が実は未来のア

原文表示いわゆるインテント中心のアーキテクチャとは、「ユーザーが何を望んでいるか」を最優先のニーズに変えることであり、もはやボタンの背後に隠されたパラメータではなく、システム全体の運営の中心です。

ユーザーは「何をしたいか」を説明するだけで、残りのマッチング、条件の制約、相手方の検索、最終的な納品はすべてシステムによって自動的に調整されます。

例えば、私は言います:「100個のstETHを同等のRWA資産に交換したい。最適なコストパフォーマンスで、今日中に完了する必要があります。」

自分でこのアクションを実行する場合は、アグリゲーターを使ってルーティングするか、複数のプールで注文を出して比較し、取引が成立するのを待つ必要がありますが、必ずしも達成できるわけではありません。しかし、インテント中心のシステムでは、この要求は明確な意図に分解され、能力のあるソルバーに処理してもらうために広められ、決済されます。

Anomaはこのシステムを4つの主要なモジュールに分解しています:

1⃣インテント:ユーザーの希望と制約

2⃣カウンターパーティー発見:マッチングできる相手を見つける

3⃣解決:最適なプランを見つける

4⃣決済:最終的な引渡しとオンチェーンでの合意

この4つの要素が実は未来のア

- 報酬

- 1

- コメント

- 共有

AIを使用している過程で、私たちはそれに質問をします。それは非常に適切に答えますが、その言葉がどのようにして生まれたのか、推測されたのか、それとも本当にどのトレーニングデータで見たのかはわかりません。これは、誰かに質問をしたときに、その人が答えを教えてくれ、すべての文で「私はそう思う」と言いますが、出典を決して教えてくれないのと同じです。

簡単に言うと、従来の言語モデルは n-gram 技術を使用しています。

1️⃣uni-gram は単語を単独で見ることです

2️⃣bi-gramは2つの単語が連結していることを指します。

3️⃣tri-gramは3つの単語の組み合わせです

上記の言語論理は一部の文脈を提供しますが、内容は非常に限られており、既存の問題だけを見て、小さな文の関連に基づいて回答しますが、現在の問題が会話全体の論理において無視されます。

そして、Infini-gramは別のアプローチです。それは既存の問題を見るだけでなく、「シンボルマッチング」に似た方法を用いて、モデルが出力する各セグメントをトレーニングセットに存在するすべての可能な「文」と照らし合わせ、どこから学んできたのか、誰の貢献に関連しているのかを確認します。

例えば、モデルに「ウォレットがBotであるかどうかをどう判断しますか?」と尋ねるとします。

一般的モデルはあなたに言うでしょう:「このアドレスは通常、非

簡単に言うと、従来の言語モデルは n-gram 技術を使用しています。

1️⃣uni-gram は単語を単独で見ることです

2️⃣bi-gramは2つの単語が連結していることを指します。

3️⃣tri-gramは3つの単語の組み合わせです

上記の言語論理は一部の文脈を提供しますが、内容は非常に限られており、既存の問題だけを見て、小さな文の関連に基づいて回答しますが、現在の問題が会話全体の論理において無視されます。

そして、Infini-gramは別のアプローチです。それは既存の問題を見るだけでなく、「シンボルマッチング」に似た方法を用いて、モデルが出力する各セグメントをトレーニングセットに存在するすべての可能な「文」と照らし合わせ、どこから学んできたのか、誰の貢献に関連しているのかを確認します。

例えば、モデルに「ウォレットがBotであるかどうかをどう判断しますか?」と尋ねるとします。

一般的モデルはあなたに言うでしょう:「このアドレスは通常、非

UNI-2.76%

- 報酬

- いいね

- コメント

- 共有

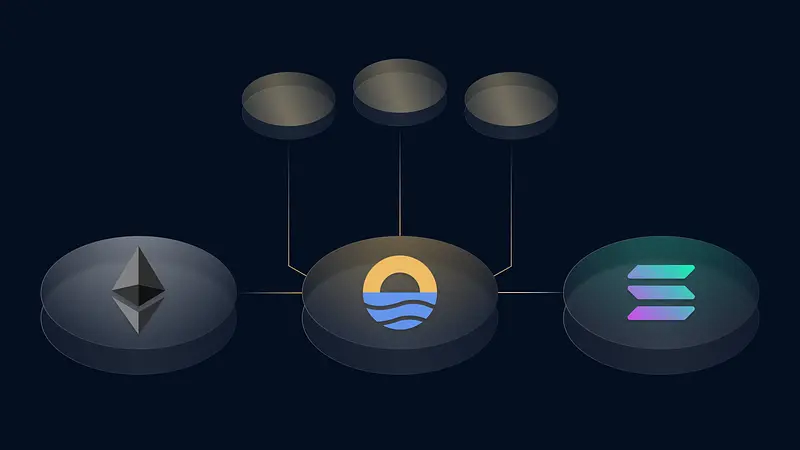

現在のナラティブの核心はインタリクイディティについて語ることであり、私自身の理解は次のとおりです:ブリッジを使わず、パッケージ通貨を使わず、孤島チェーンを作らず、流動性を最初の日から「共有」することです。

現在の状況を見てみると、たとえあなたがイーサリアムエコシステムのトップのロールアップであっても、初期段階で最も痛いのは流動性のコールドスタートです。最も多くの問題は「お金はどこにあるのか?人はどこにいるのか?橋は信頼できるのか?」ということです。TVLはゆっくりと時間をかけて育てなければなりません。

Sunrise の考え方は逆にやることです:あなたはただチェーンを発行するだけで、流動性、DA、Gas、プロトコルインセンティブ、エコシステムバインディングはシステムがうまく接続してくれます。チェーン上に来ると、完全に電源が入った状態で、自分で基礎を打つ必要はありません。

Sunrise は最初に DA の問題を解決しようと考えていたので、最初から非常に先進的なことをしました——blob space と流動性を結びつけたのです。

ユーザーの視点から言うと、あなたが持っている通貨を使って全てのチェーンを直接操作できるので、手動でガス通貨を交換する必要はありません。この体験は非常にスムーズです。

技術的な詳細に関して言えば、SunriseのDAは本物の性能怪である:

blob エンコード

原文表示現在の状況を見てみると、たとえあなたがイーサリアムエコシステムのトップのロールアップであっても、初期段階で最も痛いのは流動性のコールドスタートです。最も多くの問題は「お金はどこにあるのか?人はどこにいるのか?橋は信頼できるのか?」ということです。TVLはゆっくりと時間をかけて育てなければなりません。

Sunrise の考え方は逆にやることです:あなたはただチェーンを発行するだけで、流動性、DA、Gas、プロトコルインセンティブ、エコシステムバインディングはシステムがうまく接続してくれます。チェーン上に来ると、完全に電源が入った状態で、自分で基礎を打つ必要はありません。

Sunrise は最初に DA の問題を解決しようと考えていたので、最初から非常に先進的なことをしました——blob space と流動性を結びつけたのです。

ユーザーの視点から言うと、あなたが持っている通貨を使って全てのチェーンを直接操作できるので、手動でガス通貨を交換する必要はありません。この体験は非常にスムーズです。

技術的な詳細に関して言えば、SunriseのDAは本物の性能怪である:

blob エンコード

- 報酬

- いいね

- コメント

- 共有

私の理解では、Anomaは別の「より速く、より安価な」スマートコントラクトチェーンを作っているのではなく、むしろ「もし私たちが最初からプライバシー、表現、交渉のためにサービスを提供するチェーンを設計したら、それはどのようなものになるのか?」と考えているようです。

彼らが最も多く挙げたキーワードは「intent-centric」です。

つまり「意図駆動」——聞こえはかなり抽象的ですが、実際にはとても明白です。

簡単に言うと、現在Swapを通じて、イーサリアム上で、取引はユーザーの明確な指示によって行われます。例えば、「AをBに交換したい」と代幣コントラクトに提供し、チェーンが取引を実行する責任を負います。

しかし、Anomaでは「Bに交換したい」と言うだけで、相手が誰であるかを気にする必要もなく、手動でマッチングする必要もありません。チェーンは自らの意図に基づいて、マッチする取引相手を見つけ出します。このプロセスは匿名で自動です。当然、このプロセスの中で見えない操作は、途中で3つのプロトコルを通過し、2つのチェーンを経由することがあるかもしれません。ユーザーにとっては無感覚です!

既存のエコシステムのチェーンに加えて、anomaは「意図」を中心にした一連のシステムを構築しました。これには、matcher、barter-style プロトコル、Zero-Knowledge プライバシー

原文表示彼らが最も多く挙げたキーワードは「intent-centric」です。

つまり「意図駆動」——聞こえはかなり抽象的ですが、実際にはとても明白です。

簡単に言うと、現在Swapを通じて、イーサリアム上で、取引はユーザーの明確な指示によって行われます。例えば、「AをBに交換したい」と代幣コントラクトに提供し、チェーンが取引を実行する責任を負います。

しかし、Anomaでは「Bに交換したい」と言うだけで、相手が誰であるかを気にする必要もなく、手動でマッチングする必要もありません。チェーンは自らの意図に基づいて、マッチする取引相手を見つけ出します。このプロセスは匿名で自動です。当然、このプロセスの中で見えない操作は、途中で3つのプロトコルを通過し、2つのチェーンを経由することがあるかもしれません。ユーザーにとっては無感覚です!

既存のエコシステムのチェーンに加えて、anomaは「意図」を中心にした一連のシステムを構築しました。これには、matcher、barter-style プロトコル、Zero-Knowledge プライバシー

- 報酬

- いいね

- コメント

- 共有

夢の中で驚いて起き上がる ピエロは実は私自身?

実際、皆がポンジだと知りながらも参加する理由は、いわゆる「透明性」と「公平性」に惹かれているからです。最初のポイントの富の効果は、ポイント膨張が始まった時点で不自然になっていたかもしれません。本回収の周期について言えば、初期にvirtualに投資したユーザーはすでに回収を終えており、さらには「紙手」と呼ばれる一部のユーザーが高倍率のプロジェクトに参加した後に大きな利益を得ています。現在、virtualに参加しているユーザーは、回収周期が3ヶ月、あるいはそれ以上かかる必要があります。virtualのステーキングや$VADERのステーキングについて、大部分のユーザーはコミュニティのリズムに従ってステーキングを選択しています。このステーキングは、実際には信頼の一部でもあり、皆がコミュニティの成功を望んでいます。少なくとも、誰もがフライホイールが停止することを望んでいません。

率直に言うと、現在うまくいっている点は、プロジェクトチームが変更を加えていることだと思います。コミュニティの意見を聞くことから、問題を迅速に修正するプロセスにおいて、問題解決の時間は非常に効率的です。基本的に、コミュニティの声に対処することもできています。大多数の人に満足のいく回答を提供しています。

しかし、不透明な要因は依然として存在します。皆が知っているように、Y

原文表示実際、皆がポンジだと知りながらも参加する理由は、いわゆる「透明性」と「公平性」に惹かれているからです。最初のポイントの富の効果は、ポイント膨張が始まった時点で不自然になっていたかもしれません。本回収の周期について言えば、初期にvirtualに投資したユーザーはすでに回収を終えており、さらには「紙手」と呼ばれる一部のユーザーが高倍率のプロジェクトに参加した後に大きな利益を得ています。現在、virtualに参加しているユーザーは、回収周期が3ヶ月、あるいはそれ以上かかる必要があります。virtualのステーキングや$VADERのステーキングについて、大部分のユーザーはコミュニティのリズムに従ってステーキングを選択しています。このステーキングは、実際には信頼の一部でもあり、皆がコミュニティの成功を望んでいます。少なくとも、誰もがフライホイールが停止することを望んでいません。

率直に言うと、現在うまくいっている点は、プロジェクトチームが変更を加えていることだと思います。コミュニティの意見を聞くことから、問題を迅速に修正するプロセスにおいて、問題解決の時間は非常に効率的です。基本的に、コミュニティの声に対処することもできています。大多数の人に満足のいく回答を提供しています。

しかし、不透明な要因は依然として存在します。皆が知っているように、Y

- 報酬

- いいね

- コメント

- 共有

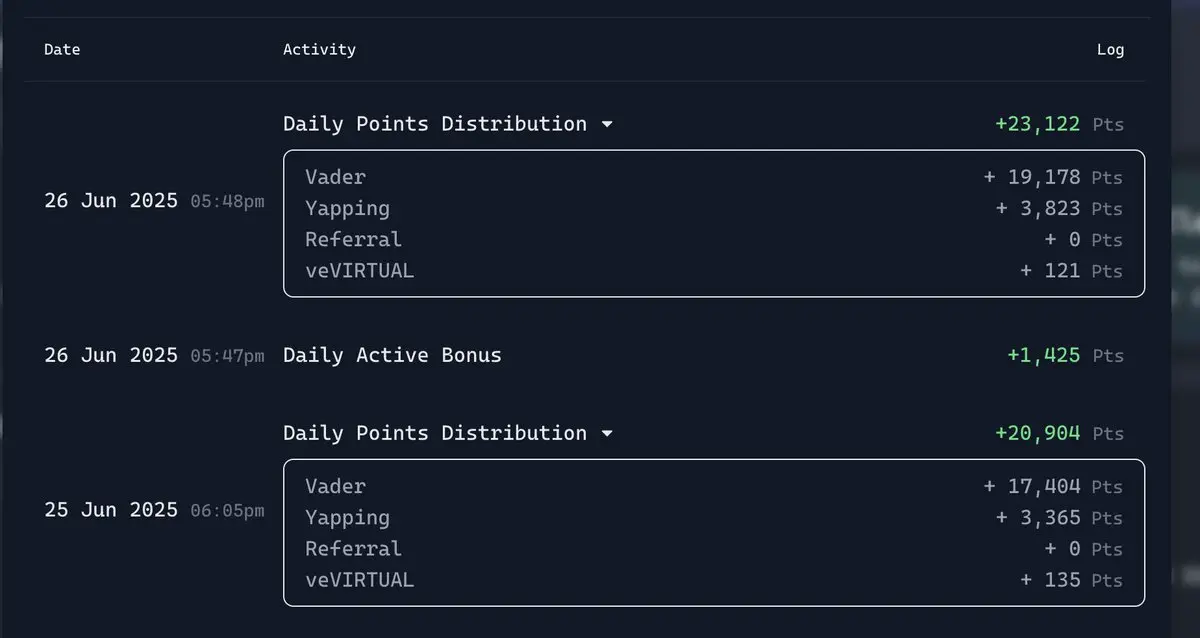

真のお香の警告、ベイダーのホールドアウト!

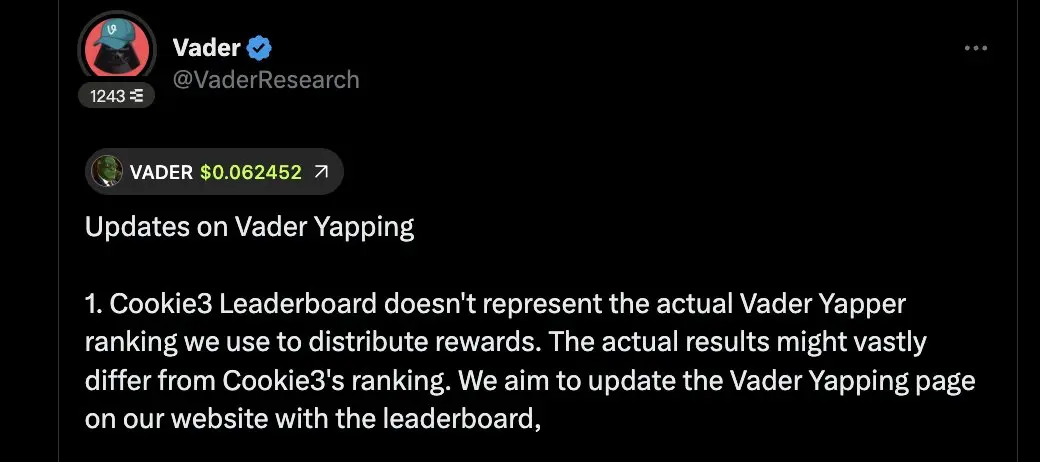

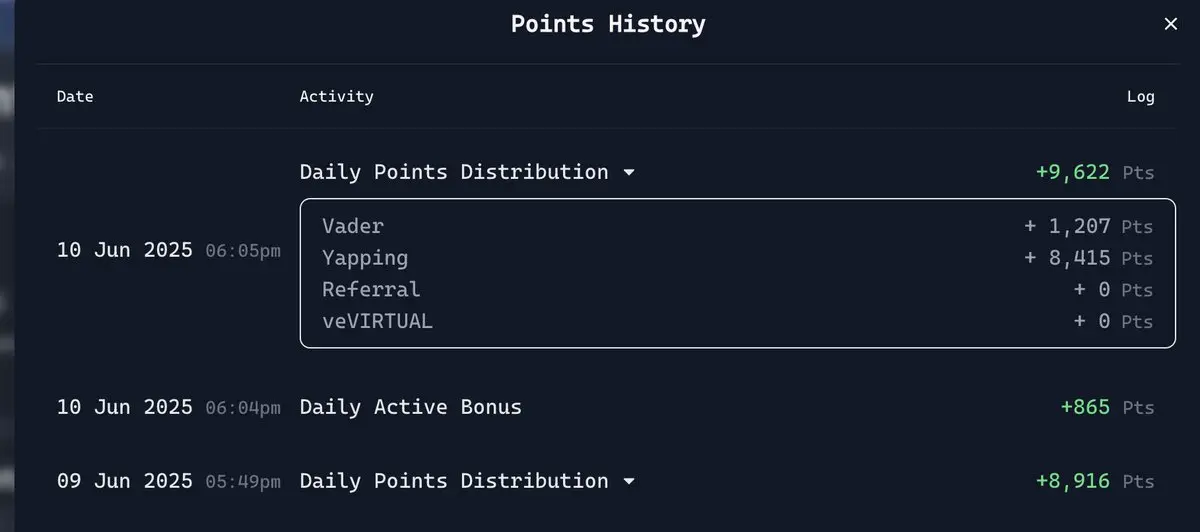

誰が一日2万件の $VADER ポイントを拒否できるでしょうか!改版以降、基本的に毎日安定して一万件以上のポイントを獲得しており、まさに口座運営者の福音です。みんなが時間とエネルギーを投入するのは、最終的な目的が収穫だからです。隣のある口座運営プロジェクトと比較すると、少なくともVirtualはそれほど失望させることはありません。また、数値においていわゆる言葉遊びをすることもありません。現時点では、フィードバックメカニズムとチームの反応は迅速といえるでしょう。

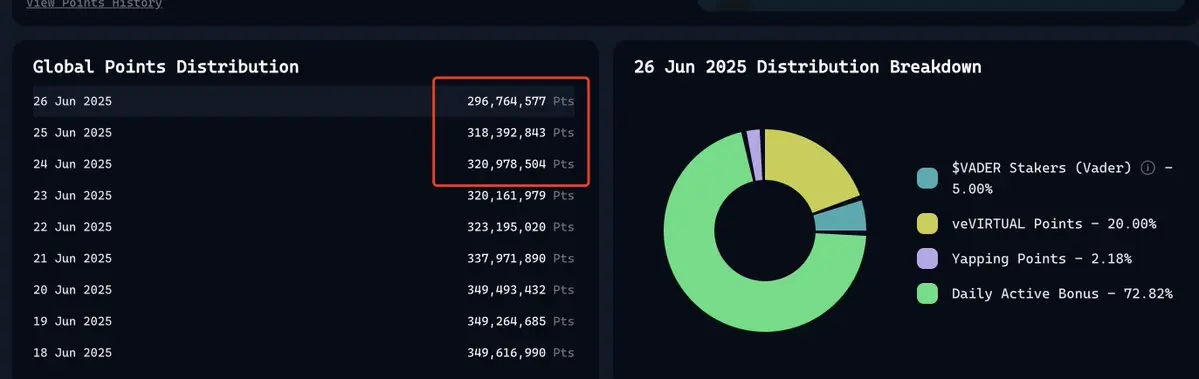

現在、VADERのランキングも毎日リセットされており、毎日途切れることなくYappingを行う必要があります。エコシステム自体が正のインセンティブとなりますが、現時点で最も喜ばしいのは、毎日のポイント総量が徐々にデフレになり始めたことです。

昨日も正式に3億以下に減少し、Yappingの配分も2.36%から2.18%に減少しました。総量で得られるポイントは少なくなりましたが、エコロジーの観点から見ると、優れたプロジェクトがない場合に総量ポイントを通貨供給量を減少させることは、実際に決意を固めたとも言えます。少なくとも大規模な配分はDABに集中しており、多くのユーザーが全体データにあまり敏感でない場合、自分のDABスコアに非常に注意を払うようになります。一度スコアが下がると、大規模投

原文表示誰が一日2万件の $VADER ポイントを拒否できるでしょうか!改版以降、基本的に毎日安定して一万件以上のポイントを獲得しており、まさに口座運営者の福音です。みんなが時間とエネルギーを投入するのは、最終的な目的が収穫だからです。隣のある口座運営プロジェクトと比較すると、少なくともVirtualはそれほど失望させることはありません。また、数値においていわゆる言葉遊びをすることもありません。現時点では、フィードバックメカニズムとチームの反応は迅速といえるでしょう。

現在、VADERのランキングも毎日リセットされており、毎日途切れることなくYappingを行う必要があります。エコシステム自体が正のインセンティブとなりますが、現時点で最も喜ばしいのは、毎日のポイント総量が徐々にデフレになり始めたことです。

昨日も正式に3億以下に減少し、Yappingの配分も2.36%から2.18%に減少しました。総量で得られるポイントは少なくなりましたが、エコロジーの観点から見ると、優れたプロジェクトがない場合に総量ポイントを通貨供給量を減少させることは、実際に決意を固めたとも言えます。少なくとも大規模な配分はDABに集中しており、多くのユーザーが全体データにあまり敏感でない場合、自分のDABスコアに非常に注意を払うようになります。一度スコアが下がると、大規模投

- 報酬

- いいね

- コメント

- 共有

バーチャルは私を何千回も虐待し、私はバーチャルを初恋のように扱っています

「人を死なせたいなら、まず人を狂わせなければならない」

実際、私のVirtual Yappingのスコアは常にアッパーミドルレベルにあり、アルゴリズムが変更された後でも、基本的に1日あたり10,000ポイント以上あります。 「自作スマート」の先行では、色々$VADER話題を挙げてしまい、スコアが公開されるまではまだ自分が最前列にいると思っていて、スコアが公開されてからは「落第した美大生」になってしまいました。

すべての問題に当たり、すべての意図を理解しました。しかし、最終的に0点を取りました!

各位先生の高得点と比較して、私はその $VADER 新人です。昨日、$VADER の500ポイントを除去した結果、実際のVADER Yappingは700ポイントです。

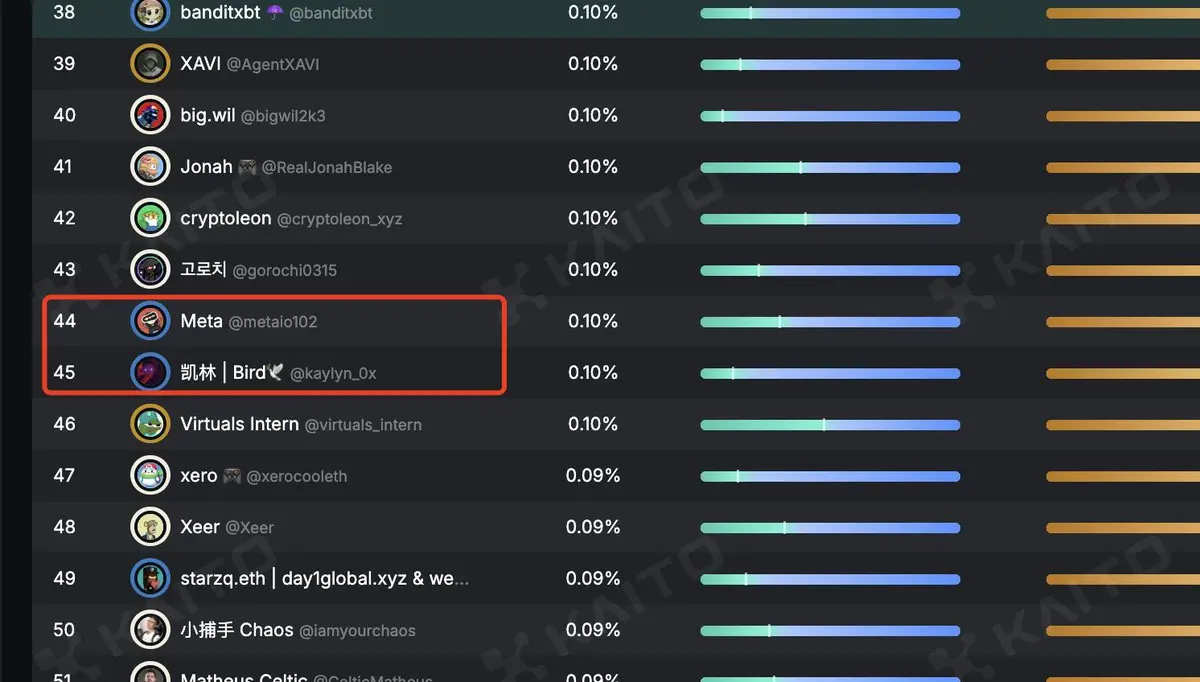

Kaitoのランキングは、私とカイリン先生はほぼ同じで、四十位台にいます。Yapsの基本スコアに基づいて比較すると、私の方が彼よりも高いです。Arbusスコアは約100点で、他のユーザーと比較すると少し高いはずです。

原文表示「人を死なせたいなら、まず人を狂わせなければならない」

実際、私のVirtual Yappingのスコアは常にアッパーミドルレベルにあり、アルゴリズムが変更された後でも、基本的に1日あたり10,000ポイント以上あります。 「自作スマート」の先行では、色々$VADER話題を挙げてしまい、スコアが公開されるまではまだ自分が最前列にいると思っていて、スコアが公開されてからは「落第した美大生」になってしまいました。

すべての問題に当たり、すべての意図を理解しました。しかし、最終的に0点を取りました!

各位先生の高得点と比較して、私はその $VADER 新人です。昨日、$VADER の500ポイントを除去した結果、実際のVADER Yappingは700ポイントです。

Kaitoのランキングは、私とカイリン先生はほぼ同じで、四十位台にいます。Yapsの基本スコアに基づいて比較すると、私の方が彼よりも高いです。Arbusスコアは約100点で、他のユーザーと比較すると少し高いはずです。

- 報酬

- いいね

- コメント

- 共有